马斯克首个编码模型上线,编程飙进Top5!这9位华人天团爆肝打造

马斯克首个编码模型上线,编程飙进Top5!这9位华人天团爆肝打造Grok首个编码模型终于来了!从0构建,编程实力超强,直接冲进SWE-bench前五,仅次于OpenAI Codex-1。背后核心团队同时被爆出,华人学者占多半。

Grok首个编码模型终于来了!从0构建,编程实力超强,直接冲进SWE-bench前五,仅次于OpenAI Codex-1。背后核心团队同时被爆出,华人学者占多半。

当地时间周一,马斯克向 OpenAI 和苹果「开炮」了! 据多家外媒报道,马斯克旗下 xAI 一纸讼书,控告它们通过 ChatGPT 和苹果 App Store 进行非法垄断。

OpenAI CEO奥特曼成为父亲后,如何重新审视人工智能与人类未来的关系?从父亲的身份到「星际之门」计划,奥特曼的转变让人深思,背后蕴含着怎样的决策哲学?

就在刚刚过去的一天,OpenAI 宣布他们与生物科技初创公司 Retro Bio 合作,研发的新模型 GPT-4b micro,设计出了新型且显著增强的山中因子变体。

刚刚,OpenAI 重大的权力结构调整曝光。 The Verge 报道称,OpenAI CEO Sam Altman 将把公司的大部分日常运营,交给 5 月任命的应用业务 CEO Fidji Simo。

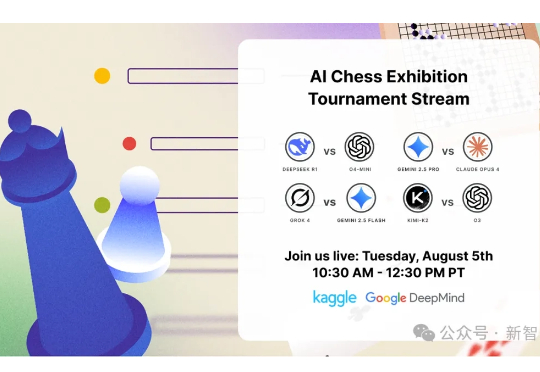

继Kaggle Game Arena的淘汰赛后,国际象棋积分赛成果出炉!OpenAI o3以人类等效Elo 1685分傲视群雄,而Grok 4和Gemini 2.5 Pro紧随其后。DeepSeek R1和GPT-4.1、Claude Sonnet-4、Claude Opus-4并列第五。

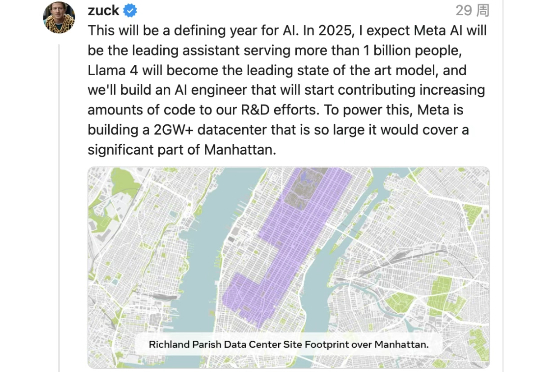

近日,据外媒消息,Meta 在本周早些时候重组了其人工智能部门后,已冻结招聘。这一举动与 Meta 此前报道的为顶尖人才提供高达 10 亿美元薪酬的计划截然不同,此前数周,该公司已从竞争对手那里挖走了 50 多名人工智能研究人员和工程师,其中包括来自 OpenAI 的 20 名研究人员和工程师,至少 13 名来自谷歌、3 名来自苹果、3 名来自 xAI 以及 2 名来自 Anthropic。

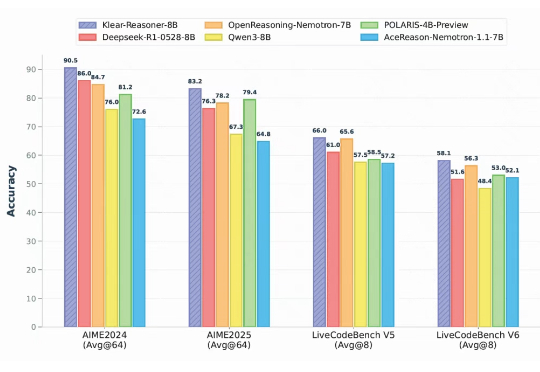

在大语言模型的竞争中,数学与代码推理能力已经成为最硬核的“分水岭”。从 OpenAI 最早将 RLHF 引入大模型训练,到 DeepSeek 提出 GRPO 算法,我们见证了强化学习在推理模型领域的巨大潜力。

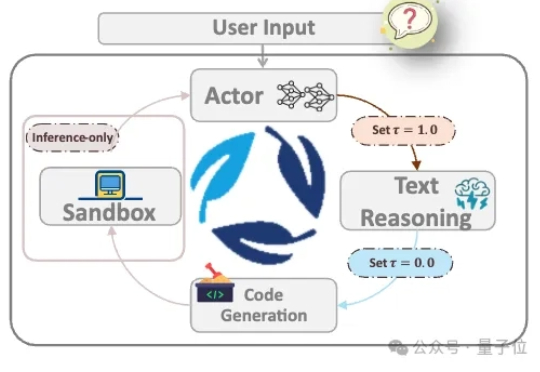

在Openai 发布o3后,think with image功能得到了业界和学术界的广泛关注。

4 个月前,OpenAI 的 o3 模型凭借视觉推理能力模块和智能的进化,在 AI 创投圈子引起新一轮的震撼与海啸,解锁了一大批新的「套壳」创业机会。正如我们在《谢谢 OpenAI,谢谢 o3,新的「套壳」创业机会来了 | 附 12 个潜力方向》一文中预测的那样,VLM 确实带来了新的创业机会。